Les modèles d’intelligence artificielle permettent de générer du texte, des images et des vidéos avec une incroyable facilité. Mais leur entrainement répétitif sur des données qu’ils ont eux-mêmes créées ferait apparaître des artefacts de plus en plus problématiques dans leurs résultats.

Depuis l’arrivée de ChatGPT, l’utilisation de modèles de langage et d’intelligence artificielle générative d’images et de vidéos a explosé et de plus en plus de données issues de ces outils se retrouvent sur Internet.

L’IA générative permet de créer des sites entiers sans qu’un humain ait à écrire un article ou à créer une image. Certains « crowd workers » les utilisent déjà pour fournir des réponses qui seront insérées dans de nouvelles bases d’entrainement. Une base de données contenant des images d’entrainement comme LAION-5B contient déjà des images générées par ce genre d’IA. Le site Have I been trained permet d’ailleurs de savoir si une image a déjà été utilisée pour entrainer des IA.

- Dangers des grands modèles de langage : des chercheuses avaient prévenu

- Tech Generation, le site qui teste ce que ChatGPT sait faire en journalisme tech

- Quand chatGPT est utilisé par les « crowd workers » pour entraîner d’autres modèles de langage

Mais nous avons encore du mal à comprendre quels impacts cette masse de contenus générés de façon automatique peut avoir sur notre utilisation d’internet ainsi que sur l’entrainement de ces IA elles-mêmes.

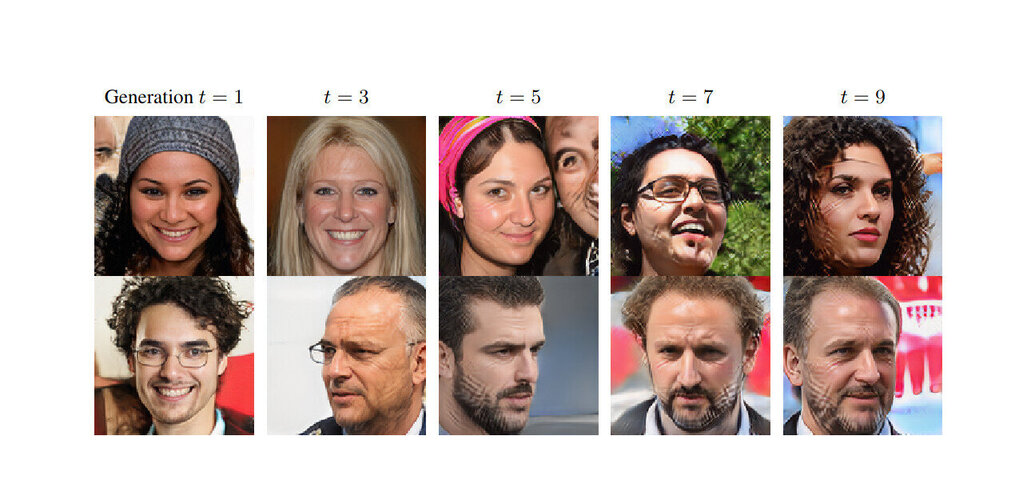

Une étude, mise en ligne [PDF] sur le site arXiv par des chercheurs des universités de Rice et de Stanford, montre qu’au bout de cinq itérations d’entrainement sur des données fabriquées par une de ces IA, celle-ci amplifie leurs biais et artéfacts de manière visible.

Mots-clés : cybersécurité, sécurité informatique, protection des données, menaces cybernétiques, veille cyber, analyse de vulnérabilités, sécurité des réseaux, cyberattaques, conformité RGPD, NIS2, DORA, PCIDSS, DEVSECOPS, eSANTE, intelligence artificielle, IA en cybersécurité, apprentissage automatique, deep learning, algorithmes de sécurité, détection des anomalies, systèmes intelligents, automatisation de la sécurité, IA pour la prévention des cyberattaques.