Alors que les travaux se multiplient pour réguler le domaine de l’intelligence artificielle, l’équipe du Centre de recherche sur les modèles de fondation de Stanford dévoile un index d’analyse de la transparence des modèles d’IA généralistes. Résultat de la toute première analyse : tout le monde peut (largement) mieux faire.

Llama 2, Bloomz, GPT-4… L’intelligence artificielle est revenue sur toutes les lèvres avec l’explosion des modèles génératifs, il y a un an tout juste, qui a créé son lot d’excitation et d’anxiété. La transparence des modèles algorithmique, elle, est un axe de travail promu par le milieu scientifique depuis une bonne dizaine d’années, pour faciliter la confiance et la bonne adaptation de ces nouvelles technologies.

Pourtant, selon une étude menée par Rishi Bommasani et plusieurs autres chercheurs du Center for Research on Foundation Models (CRFM) de l’Institute for Human-Centered Artificial Intelligence (HAI) de Stanford, ni Meta, ni Hugging Face, ni Open AI (qui contient pourtant le mot « open » dans son nom) ni Google n’explosent les scores en matière de transparence de leurs « modèles de fondation » (un terme proposé par le même CRFM en 2021 pour qualifier des modèles algorithmiques généralistes, qui peuvent être adaptés pour réaliser une grande variété de tâches). Selon les scientifiques, ils sont même de moins en moins transparents.

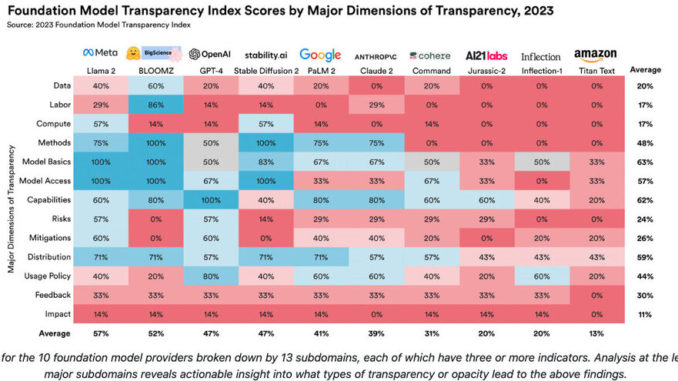

Pour objectifier le phénomène, l’équipe a en effet construit un index de la transparence des modèles de fondation. L’outil comprend 100 indicateurs, dont le but est d’aider à composer une image précise du fonctionnement d’un modèle algorithmique en fonction de la manière dont il est fabriqué, dont il fonctionne, et dont ce fonctionnement influe sur ses diverses applications.

Sur cette échelle de 100, le meilleur résultat de transparence revient au modèle Llama 2 de Meta (54 %), suivi du BLOOMZ de Hugging Face (53 %) puis du GPT-4 d’Open AI.